Uso de IA para criar imagens íntimas sem consentimento pode dar prisão e multa

Caso da ferramenta de geração de imagens que criou milhões de conteúdos sexualizados alerta para crimes e falhas na regulação das plataformas de IA em todo o mundo

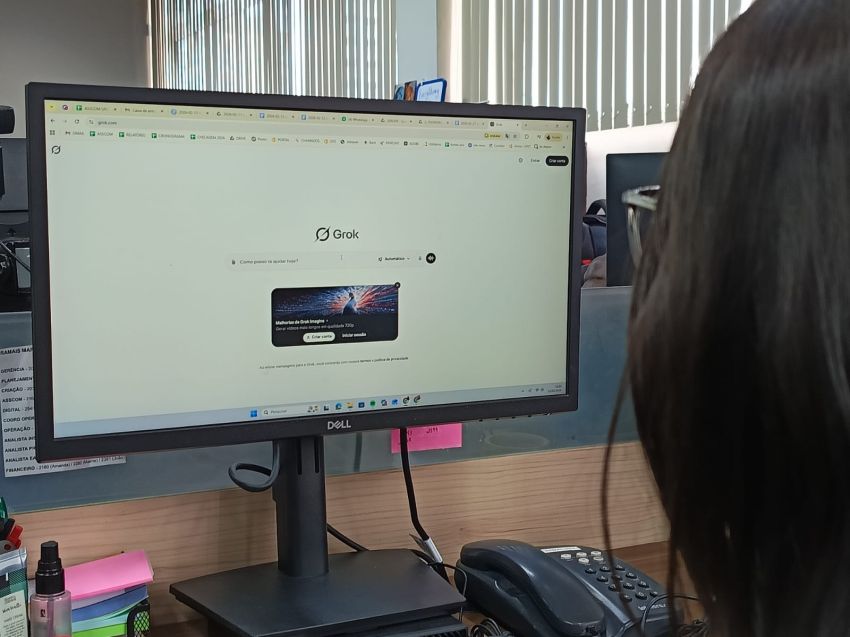

O debate sobre a regulação das plataformas e empresas de inteligência artificial foi reavivado pelo escândalo recente do chamado Caso Grok, que envolve o uso do Grok, chatbot de IA que funciona com a rede social X (antigo Twitter) para a criação de imagens de mulheres e até de crianças e adolescentes em trajes íntimos ou situações de prática sexual. Uma investigação da ONG britânica Centro de Combate ao Ódio Digital (CCDH, da sigla em inglês), apontou que, em apenas 11 dias, entre dezembro de 2025 e janeiro de 2026, o Grok gerou cerca de 3 milhões de imagens sexualizadas e até pornográficas, envolvendo até pessoas famosas, incluindo cantoras, atrizes, atletas, modelos, influenciadoras e líderes políticas. Isto aconteceu através da ferramenta de geração de imagens com IA que foi inserida nesta versão da plataforma: a Grok Imagine.

As denúncias não tardaram a repercutir em todo o mundo. Elon Musk, a princípio, debochou do assunto e até incitou a produção de mais imagens, através de seu perfil no X. mas recuou e impôs restrições após o Grok passou a ser alvo de ações judiciais nos Estados Unidos, de bloqueios em países como Turquia, Malásia e Indonésia; e de investigações no Japão e na União Europeia. E no Brasil, houve procedimentos do Ministério Público Federal (MPF), da Agência Nacional de Proteção de Dados (ANPD), da Polícia Civil do Rio de Janeiro e da Secretaria Nacional do Consumidor (Senacon), ligada ao Ministério da Justiça.

A distorção de imagens com fins sexualizadores ou difamatórios com uso da IA incorre em uma série de crimes tipificados legalmente. A começar pelo Código Penal brasileiro, que, em seu artigo 218-C, prevê de um a cinco anos de prisão para quem divulgar cenas de sexo, nudez ou pornografia sem consentimento. Há ainda a LGPD (Lei Geral de Proteção de Dados), que considera o rosto e o corpo de uma pessoa como dados biométricos e impõe multas de até R$ 50 milhões para a empresa que os usar sem autorização. E o Código Civil garante que a vítima seja indenizada por danos morais e à sua honra.

Todos os chatbots de IA, como o ChatGPT e o Google Gemini, são dotados de funções para processar e analisar imagens a partir de dados de outras pessoas, mas a maioria deles têm políticas internas de restrições para esta prática, principalmente em casos sensíveis, com situações de nudez e violência. Já o Grok, por decisão inicial de Elon Musk, não vinha adotando nenhum filtro ou controle para a recepção e a criação de imagens. “Ele foi desenhado justamente para ser o oposto de modelos mais 'comportados', como o ChatGPT ou o Gemini. Como ele nasceu com essa promessa de liberdade total e menos filtros, acabou facilitando muito esse tipo de abuso”, pontua a gerente de Processos, Resultados e LGPD da Universidade Tiradentes (Unit), Suzan Kelly Oliveira.

Ela destaca que a manipulação criminosa das imagens e dados através de um processo considerado como o mais perigoso: a transferência de imagem para imagem, que cria o chamado deepfake. “Em vez de a IA criar um desenho do zero, o usuário entrega uma foto real de alguém. A máquina usa o rosto e o corpo daquela pessoa como um molde e reconstrói o resto. O resultado é assustador: ela consegue criar imagens pornográficas ou sexualizadas com um realismo tão alto que fica difícil distinguir o que é verdade, destruindo a reputação da vítima em questão de segundos”, descreve Suzan, ao considerar que a prática da Grok provocou uma “violação em cascata” dos direitos das vítimas. “Primeiro, o direito à imagem e à honra. Segundo, o direito à autodeterminação informativa, que é o poder do indivíduo de controlar como seus dados (incluindo seu rosto) são usados. No caso de mulheres, há uma clara violação da dignidade da pessoa humana e o direito de não ser submetida a violência de gênero, já que o uso não consentido de imagem para fins sexuais é uma forma de abuso psicológico e moral”, afirma.

Como acontece

A função de manipular imagens, incluindo fotos e vídeos, é uma das capacidades da chamada IA Generativa, área especializada na criação de textos, imagens, áudios e códigos, com base em dados fornecidos por comandos humanos (chamados de prompts). O professor Victor Flávio de Andrade Araújo, dos cursos de Tecnologia da Informação (TI) da Unit, explica que esta área evoluiu rapidamente com o surgimento de computadores mais poderosos, capazes de lidar com muitos dados.

“A partir disso, nós da computação conseguimos criar modelos estatísticos que fazem a máquina aprender padrões em um banco de dados imenso. Por exemplo: se eu tenho a capacidade de armazenar e processar informações de dezenas de milhares de imagens da internet, consequentemente, eu consigo entender padrões específicos dessas imagens. A partir deste entendimento, muitas pesquisas científicas de grandes empresas começaram a tentar replicar esses padrões a partir dos dados já conhecidos (das informações já conhecidas). Aí entra a IA generativa, ou seja, eu preciso de uma grande quantidade de informações para aprender um padrão e criar algo em cima deles (replicar)”, explica Victor.

Apesar da alta capacidade dos programas e das máquinas de IA, com seus modelos e padrões pré-definidos, elas não têm a capacidade de fazer essas manipulações ou criações por iniciativa própria. Ou seja: o tom e a conotação a serem dados para cada imagem criada é geralmente ditado por um comando humano que precisa dizer, de forma específica e clara, o que ele quer do chatbot. “No entanto, esses modelos precisam de dados para relacionar e criar, o que a gente chama de modelo contrastivo (de contraste). Exemplo: se eu crio um contexto muito específico, como "quero a imagem de um gato branco com laço vermelho, de botas azuis, e que tenha olhos verdes", então o modelo de IA vai descartar tudo o que não tiver relações com isso em sua base de informações”, detalha o professor, observando que os programas de IA usam informações disponíveis em toda a internet.

Regular é preciso

Em outros países, a atuação das plataformas de IA também é regulamentada por leis gerais ou específicas. A União Europeia, com a sua Lei da IA (AI Act), classifica os sistemas geradores de deepfakes como de “alto risco” e exige estrita transparência. Nos EUA, estados como o da Califórnia possuem leis específicas contra a “pornografia de vingança” gerada por IA. E a China acaba de baixar a sua regulação de Inteligência Artificial, um sistema modular de regras que serão lançadas pelo governo a depender da evolução de cada tecnologia, piscando manter a estabilidade social e a soberania tecnológica.

Para a gerente da Unit, o Caso Grok chama a atenção para a “necessidade urgente” de uma autoridade global ou transnacional para regular as tecnologias de IA. “O ideal seria termos uma espécie de 'Lei da IA Global' ou um tratado internacional de peso, algo comparável ao que temos hoje como grandes acordos climáticos. Precisamos estabelecer padrões mínimos de segurança e ética que valham para todos. Sem esse alinhamento global, corremos o risco de ver empresas buscando 'paraísos regulatórios', ou seja, países com leis frouxas onde elas possam hospedar modelos sem nenhum tipo de filtro ou responsabilidade. Um tratado transnacional impediria essa fuga de responsabilidade e garantiria que, independentemente de onde a tecnologia venha, o respeito à dignidade humana seja o mesmo em qualquer lugar do planeta”, afirma Suzan.

“Se o Brasil tem determinadas leis para proteção de dados, então eu acho que nenhum desses modelos deveriam manipular nossas fotos e reproduzi-las sem nosso consentimento. A partir disso, assim como o GPT, por exemplo, eu acho que o Grok poderia bloquear alguns assuntos sensíveis. E, esse é um caso sensível. A empresa do Grok tem como colocar "amarras" em determinados assuntos para que o modelo não crie imagens sexualizadas, de amputamento, que mostre sangue, etc. Principalmente, sendo imagens de pessoas”, completa o professor Victor Flávio.

Autor: Gabriel Damásio

Fonte: Asscom Unit